Разработка под ЛС. 1000 руб/час

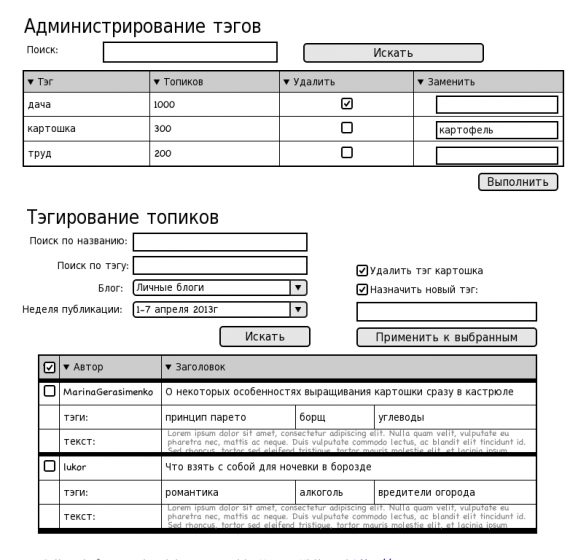

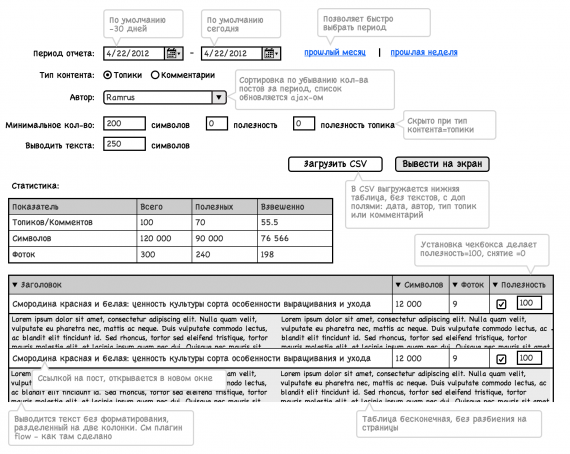

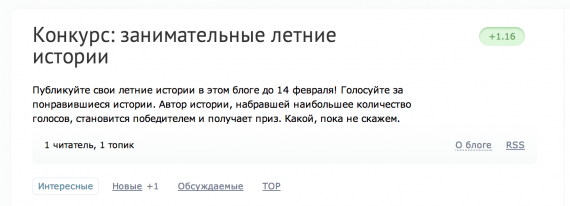

Много разных задач по редизайну сайта www.7dach.ru

Новый дизайн в процессе — dev2.habicasa.ru

Нужен человек, готовый погрузиться в проект и тратить на него 15-30 часов в неделю.

Предоплату мы не делаем. Для разработки готовы предоставить настроенный тестовый сервер. Начинаете работать, выполнять сначала мелкие задачи, их сразу оплачиваем по факту выполнения.

Все вопросы пишите в личку или skype — ddegtyarev

UPD:

1. Мы не оплачиваем стратегический консалтинг, инновационные идеи, философские размышления. Мы оплачиваем кодинг в виде коммитов в нашу репу.

2. У нас нет интересных или прикольных задач, решение которых прославит вас или обогатит новыми знаниями. Есть задачи по кодингу согласно подробному ТЗ, в виде тасков в нашей репе (github)

3. Весь оплаченный нами код становится нашей собственностью, и перестает быть вашей.

4. Наш проект требует погружения. Работать по полчаса в день не получится.

5. Если вас не мотивируют деньги, мы вряд ли будем вам интересны.

6. Если вы не можете оперативно отвечать на скайп/почту/лс в рабочее время, или хотя бы обозначить период, когда возможна такая коммуникация, мы не захотим с вами работать.

UPD2:

Я в отпуске по 2 июля, отвечать на письма в это время скорее всего не смогу.

Новый дизайн в процессе — dev2.habicasa.ru

- Есть задачи чисто CSS

- Есть задачи jQuery, в т.ч. интеграция Aloha Editor

- Есть задачи под PHP

- Есть задачи по доработке модулей Nginx

Нужен человек, готовый погрузиться в проект и тратить на него 15-30 часов в неделю.

Предоплату мы не делаем. Для разработки готовы предоставить настроенный тестовый сервер. Начинаете работать, выполнять сначала мелкие задачи, их сразу оплачиваем по факту выполнения.

Все вопросы пишите в личку или skype — ddegtyarev

UPD:

1. Мы не оплачиваем стратегический консалтинг, инновационные идеи, философские размышления. Мы оплачиваем кодинг в виде коммитов в нашу репу.

2. У нас нет интересных или прикольных задач, решение которых прославит вас или обогатит новыми знаниями. Есть задачи по кодингу согласно подробному ТЗ, в виде тасков в нашей репе (github)

3. Весь оплаченный нами код становится нашей собственностью, и перестает быть вашей.

4. Наш проект требует погружения. Работать по полчаса в день не получится.

5. Если вас не мотивируют деньги, мы вряд ли будем вам интересны.

6. Если вы не можете оперативно отвечать на скайп/почту/лс в рабочее время, или хотя бы обозначить период, когда возможна такая коммуникация, мы не захотим с вами работать.

UPD2:

Я в отпуске по 2 июля, отвечать на письма в это время скорее всего не смогу.